本報訊 近年來,AI的發展遵循著一個簡單直接的規則——模型越大、能力越強。這個被稱為“規模法則”的路徑,催生了今天我們看到的各種強大的AI大模型。但同時,隨著模型參數量的增大,模型訓練的成本、使用的成本也隨之飆升,一定程度上制約了大模型的產業應用進程。

清華大學的一項最新研究成果——大模型“密度法則”20日在國際期刊《自然·機器智能》上作為封面文章發表,為AI發展指出了一個新方向:AI大模型變強,不應只靠“體型”,更要靠“密度”。

圖為刊載清華成果的《自然·機器智能》封面圖。新華社發

“過去,我們往往關心一個AI模型的‘塊頭’有多大,即參數量有多大,其實我們更應該關心模型的‘能力密度’,即每個單位的參數能展現出的智能水準。”論文第一作者、清華大學電腦科學與技術系助理研究員肖朝軍說,“這就好比評價一個武林高手,不是看他塊頭有多大,而是看他一招一式裏蘊含了多少功力。”

研究人員表示,實現這樣的“能力密度”,不能靠“模型壓縮”。研究發現,強行壓縮一個大模型,就像是把一本厚厚的字典強行塞進小本子裏,很多內容會丟失,導致“智力”下降,因此需要採用更先進的“數據+算力+演算法”體系,才能培養出“高密度”的精幹小模型。

通過研究過去幾年發佈的51個開源大模型,研究人員發現:AI大模型的“能力密度”正以指數級速度增長,大約每3.5個月就翻一倍。

這意味著什麼?打個比方,如果今天我們需要一個體育館大小的“大腦”才能完成某項複雜任務,那麼約3個半月後,我們只需要一個客廳大小的“大腦”就夠了;再過3個半月,這個“大腦”可能只需要一個背包大小。

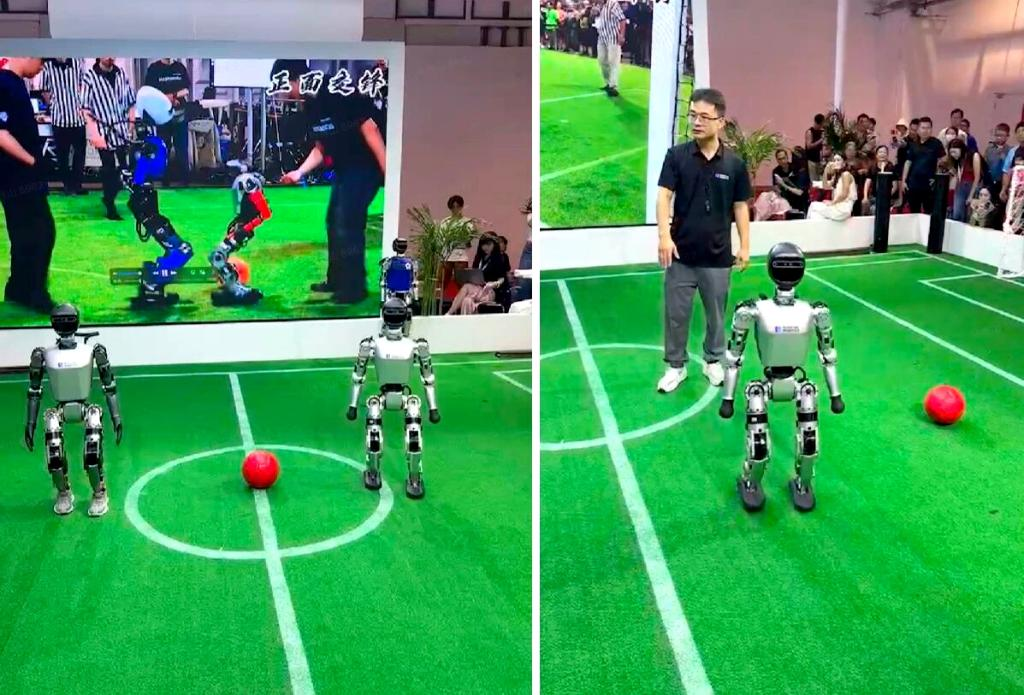

圖為清華大學與面壁智能開發的“高密度”端側模型應用於機器人。新華社發

據瞭解,目前,清華大學已與AI企業面壁智能的團隊合作推出了系列“高密度”模型,已應用於手機、汽車、智能家居等生活領域。

“AI模型不是越大越好,‘精煉’‘高效’是其未來發展的方向。”肖朝軍說,強大的AI大模型在未來將會更廣泛地在手機、電腦、汽車等終端上運行。當晶片的計算能力和AI的智能密度這兩條快車道交匯時,“端側智能”的時代或將來臨。屆時,個人設備有望擁有前所未有的智能,不僅反應更快,還能更好地保護個人隱私。 (魏夢佳)